Posted: 23 Dec 2008En el mundo quedan muy pocos lugares inexplorados por científicos y este descubrimiento es realmente increíble porque investigadores encontraron un bosque en Mozambique que nunca había sido visitado anteriormente a través de Google Earth (Oh, dios Google, nosotros nos arrodillamos ante ti).El lugar se llama Monte Mabu y hasta ahora no

aparecía en los mapas ni en ningún libro ya que nunca había sido explorado. Un científico británico llamado Julian Bayliss estaba buscando posibles precipitaciones a través de la aplicación de Google y, de casualidad, dio con este bosque de 80 kilómetros cuadrados todavía inexplorado.Fueron 28 científicos de Reino Unido, Mozambique, Malawi, Tanzania y Suazilandia en octubre hacia la región acompañados por 70 porteadores. Jonathan Timberlake, responsable de la expedición, explicó que no se dieron cuenta de la importancia del descubrimiento hasta que volvieron a Londres y comenzaron a examinar los resultados.En el lugar había árboles de 45 metros de altura, tres nuevas especies de mariposa, una de serpiente y muchas nuevas plantas desconocidas.

Realmente no puedo imaginar lo que debe ser conocer un lugar donde nunca habitó el hombre. Poder ver la naturaleza intacta que creció sin nuestras “molestias” a través de miles de años debe ser de las cosas más emocionantes que pueda imaginarme.

07:16 AM PST

lunes, 29 de diciembre de 2008

Encuentran un bosque inexplorado en Mozambique a través de Google Earth

jueves, 18 de diciembre de 2008

Planetas inestables pueden ayudarnos a encontrar satélites como la Tierra

Lunas de países exteriores a nuestro Sistema Solar que tengan potencial para soportar vida se han convertido más fáciles de detectar, gracias a una investigación de un astrónomo de la Universidad de Londres.

David Kipping ha encontrado que este tipo de satélites pueden ser revelados observando la inestabilidad en la velocidad de los planetas que orbitan. Sus cálculos no sólo nos confirmarían si el planeta tiene un satélite sino que también podríamos calcular su masa y su distancia a dicho planeta, factores determinantes para sopesar si puede albergar vida o no.

De los más de 300 exoplanetas (planetas exteriores al Sistema Solar) actualmente conocidos, casi 30 de ellos están en la zona que definiríamos habitable respecto a su estrella, aunque estos planetas son inhabitables por ser gigantes gaseosos. La búsqueda de estas lunas es importante, ya que siguen estando en esa zona habitable, pero son más parecidos a nuestro planeta, lo que podría ser un paso a la hora de descubrir vida extraterrestre.

"Hasta ahora, los astrónomos sólo habían observado los cambios enla posición de un planeta a la hora de orbitar su estrella, lo que hacía difícil confirmar la presencia de una luna, pero adoptando este nuevo método y observando la variación en la posición del planeta y en su velocidad cada vez que pasa por delante de la estrella, ganamos información veraz y tenemos la capacidad de detectar lunas de masa parecida a nuestro planeta alrededor de un planeta del estilo de Neptuno".

La inestabilidad en la velocidad y la posición de un planeta es causada porque el planeta y su satélite orbitan respecto a un mismo centro de gravedad.

"Reunir tanta información es emocionante", dice el profesor Keith Mason. "Si alguno de estos planetas tiene satélites, como Júpiter o Saturno, existe una gran posibilidad de que alguno sea como nuestro planeta".

Powered by ScribeFire.

lunes, 15 de diciembre de 2008

Cómo destruir un asteroide

Los astrofísicos coinciden: la mejor forma de evitar una colisión que resultaría catastrófica sería cambiar el curso del asteroide que le lleva a nuestro planeta. "Para que esto funcione, necesitamos ser capaces de predecir que pasaría si intentamos una explosión", dice David Polishook, un doctor de la Universidad de Tel Aviv. Es uno de los pocos científicos que tratan de investigar la composición y su estructura para aprender cómo enfrentarse a ellos en caso de un hipotético futuro impacto contra nuestro planeta, cosa que no sería tan rara, después de todo.

Habría que destruirlo antes de que llegara a nuestra atmósfera. Pero explotar un asteroide podría crear numerosos asteroides pequeños, de unos 100 metros de diámetro, que caerían sobre la superficie terrestre. Estos fragmentos de asteroide serían el doble de grande que el que provocó el famoso cráter de Arizona.

"Los científicos tenemos que conocer cómo es la estructura de los asteroides, si son piezas sólidas de piedra unidas, conocer las fuerzas que las mantienen unidas, y entender cómo se comportarían si lo bombardeamos". Observando los asteroides, Polishook es capaz de examinar la forma, el periodo de rotación y la composición de la superficie de los asteroides.

Como siempre, para destruir a tu enemigo, primero tienes que conocerlo.

Fuente:

Powered by ScribeFire.

Misteriosa pirámide descubierta en México sería de una cultura antes desconocida

Pirámide en MéxicoLos objetos fueron descubiertos hace unos 15 años en el valle de Tulancingo, un gran cañón que termina en la costa del Golfo de México. 41 artefactos que no se parecen a los de ninguna cultura mexicana, según Carlos Hernández, arqueólogo del Instituto Nacional de Antropología de México.

Muchas de las figuras son personas sentadas con sus manos sobre las rodillas. Algunos tienen sombreros con serpientes, que podrían representar al dios azteca Quetzalcóatl. Las esculturas están hechas de un material que combina arena, limo y agua, y pintadas de azul o verde para que se parezcan al jade.

Se creen que son del período epiclásico entre el año 600 y el 900. Según dijo Hernández algunos arqueólogos creen que las esculturas no son antiguas o que son falsas, pero se ha comprobado que no es así. “Vinculando todas las características”, dice, “ que hacen diferentes a estos artefactos, nos permite decir que deben ser consideradas como el producto de una cultura diferente llamada Huajomulco”.

Pero lo más interesante es que los artefactos fueron descubiertos cerca de la misteriosa pirámide Huapalcalco, ubicada en Hidalgo. El origen de esta pirámide ha sido ampliamente debatido entre los arqueólogos.

La proporción de la pirámide, mas estructuras menores pintadas de negro y blanco, no corresponden ni a los Toltecas ni a Tehotihuacan, culturas que estaban en la zona para ese período.

Y la alfarería descubierta en el yacimiento tampoco resulta familiar para los arqueólogos. Hernandez cree que la pirámide debe haber sido construida por esta cultura desconocida.

Thomas Charlton, arqueólogo estadounidense de la universidad de Iowa, que trabaja en la zona, también cree que se trata de una nueva cultura. Se trataría de una que existió entre la caída de Teotihuacan y el comienzo del poderío Tolteca.

Tras la caída de Teotihuacan aparecieron numerosos estados pequeños en México, parte del ciclo de la caída de un imperio. Así que no sería nada raro que se descubra una cultura antes desconocida de ese período de tiempo.

Fuente: National Geographic

Powered by ScribeFire.

miércoles, 8 de octubre de 2008

Fraude científico

Casos de mala ciencia disparan la alarma social. Esto es lo que ocurrió con un estudio recogido en la revista médica The Lancet, que sugería una relación entre la vacuna triple vírica y el autismo. Al cabo de seis años el fraude queda al descubierto, pero el número de niños en Reino Unido sin vacunar aumentó durante ese tiempo. ¿Cómo evitar el fraude científico?

| Rosa Sancho CINDOC |

1. Definición y clases de fraudes científicos |

Un famoso botánico engañó a la comunidad científica con falsos descubrimientos

| El respetado botánico británico John Heslop-Harrison (1881-1967), que se hizo famoso por el descubrimiento de docenas de especies vegetales en las Islas Hébridas escocesas, plantó las semillas de las plantas que después aseguró haber descubierto. | |

| FUENTE | Agencia EFE | 03/10/2008 |

| |

tivo británico «The Times», el Museo de Historia Natural de Londres tiene en su poder archivos confidenciales que indican que el botánico reunió semillas durante sus viajes, las plantó en las islas escocesas y luego falseó sus descubrimientos. Todo por la fama.

tivo británico «The Times», el Museo de Historia Natural de Londres tiene en su poder archivos confidenciales que indican que el botánico reunió semillas durante sus viajes, las plantó en las islas escocesas y luego falseó sus descubrimientos. Todo por la fama.Sus catalogaciones de raras plantas, que apoyaban la hipótesis de que la edad de hielo no llegó a Escocia, le permitieron forjarse una gran reputación en el mundo de la botánica hace sesenta años.

Sus hallazgos más importantes se dieron en la isla de Rúm (oeste de Escocia) a finales de los años 40, donde «descubrió» la especie «carex bicolor», una extraña juncia, y el junco «capitatus».

Algunas de las especies descubiertas eran comunes en los Alpes, pero nunca se habían encontrado tan al norte.

La presencia de carex bicolor en Escocia apoyaba la hipótesis de que la edad de hielo no había alcanzado las islas y por eso muchas especies de plantas habían sobrevivido.

Las primeras dudas respecto al trabajo de Heslop-Harrison surgieron entre algunos colegas contemporáneos, como John Raven, quien explicó en un documento que el «carex» y el junco parecía que acababan de plantarse y dijo no haber encontrado más muestras en Rúm que las documentadas por el botánico.

Sin embargo, la reputación e influencia de Heslop-Harrison, que era académico y miembro de la Royal Society y cuyo hijo ostentaba el cargo de director de los Jardines Botánicos Reales de Kew, impidieron que se destapara el fraude.

Según explica «The Times», se descartó poner al descubierto su fraude porque el botánico estaba al final de su carrera y sería un «duro golpe» hacerlo.

Las sospechas de Raven quedaron enterradas en una biblioteca de Cambridge hasta que en 1999 el autor Karl Sabbagh las publicó en un trabajo que sacaba a la luz las sospechas acerca de Heslop-Harrison.

Su libro hizo que una legión de admiradores del botánico salieran en su defensa.

Pero Sabbagh, empeñado en descubrir la verdad, ha tenido acceso a documentos que demuestran que el hasta ahora respetado botánico falseó sus descubrimientos.

El aniversario más austero de la NASA

| A lo largo de sus cincuenta años de historia, la NASA ha pasado de ser un interés prioritario del Gobierno de Estados Unidos a ser una agencia costosa de mantener, cuyos proyectos quedan aplazados por falta de presupuesto. | |

| FUENTE | Expansión | 01/10/2008 |

| |

La Administración Nacional de Aeronáutica y del Espacio (NASA) celebra, entre noticias sobre el aplazamiento de la misión del transbordador espacial Atlantis, medio siglo de existencia con una larga lista de misiones y exitosos lanzamientos espaciales. Sin embargo, la NASA no atraviesa uno de sus mejores momentos. Durante los últimos años, la agencia espacial estadounidense ha tenido que luchar con uñas y dientes para conseguir lo más importante: dinero. En 1958 su presupuesto fue de 500 millones de dólares (cifra actualizada según la inflación de 2007) y alcanzó la cima en 1967 con 29.7000 millones de dólares, cuando la NASA todavía perseguía el sueño del presidente John F. Kennedy de llevar a un hombre a la Luna.

El impresionante gasto militar de EE.UU. ha querido que el dinero cambie de manos y la agencia espacial tendrá que conformarse con 17.614 millones de dólares para financiar sus misiones en 2009. Aunque la cifra es elevada, este nuevo presupuesto prácticamente anula todo el programa de exploración marciana que estaba previsto para la próxima década y lo deja en una situación incierta. La comunidad científica no ha tardado en expresar su malestar a la Administración Bush que ha obligado a la NASA a desarrollar nuevos cohetes y naves para ir a la Luna, pero no la ha dotado de dinero para hacerlo.

El presupuesto destinado a la investigación científica ha caído a 264,7 millones de dólares, creciendo solamente un 1% en relación al del año pasado. Este dato resulta alarmante si se tiene en cuenta que este tipo de estudio es esencial para la evolución de la sociedad. "La investigación espacial ha permitido mejorar el conocimiento de la física de una manera brutal. Además, muchas de las tecnologías que se han desarrollado para las misiones espaciales terminan aplicándose en la Tierra, como ha sucedido en la medicina", explica Andrés Ripoll, ingeniero aeronáutico de la NASA durante programa Apollo y miembro de la Real Academia de Ingeniería. "Unos 50.000 sistemas han sido patentados y más de la mitad han sido utilizados para mejorar la sanidad", añade.

Quizá la entrada de China en la carrera espacial -el lunes el gigante asiático recibió como héroes a sus tres taikonautas tras realizar el primer paseo espacial de su historia- impulse una vez más la inyección de dinero en este tipo de proyectos para, por ejemplo, llegar de nuevo a la Luna.

LA ÉPOCA DORADA DE LA NASA

La ironía quiso que la aventura de la agencia espacial estadounidense comenzara su andadura tras la puesta en órbita el 4 de octubre de 1957 del Sputnik 1, primer satélite artificial del mundo, lanzado por el eterno enemigo, la Unión Soviética.

Tanto el presidente Dwight D. Eisenhower como el Congreso de Estados Unidos percibieron este hito como una amenaza para la seguridad del país y decidieron crear una agencia federal que dirigiera la actividad espacial no militar. La NASA empezó a funcionar el 1 de octubre de 1958, con un único objetivo: no permitir que la URSS ganara la denominada carrera espacial.

La agencia inició sus operaciones inmediatamente con el programa Mercury. Este proyecto tenía una meta simple, saber si el hombre podría sobrevivir en el espacio exterior. Alan B. Shepard, Virgil I. Grissom, Gordon Cooper, Walter Schirra, Deke Slayton, John Glenn y Scott Carpenter, conocidos como los siete de Mercury, fueron los pilotos escogidos para enfrentarse a la incógnita del cosmos. El 5 de mayo de 1961, Alan Shepard se convirtió en el primer astronauta estadounidense al pilotar el Libertad 7 en un vuelo suborbital de 15 minutos.

Veinte días después del acontecimiento, el presidente John F. Kennedy se comprometió a llevar "un hombre a la Luna y devolverlo sano y salvo a la Tierra antes del final de la década". La NASA cambió sus planes y aceptó el reto. El 20 de junio de 1969, Neil Armstrong y Edwin E. Aldrin alunizaron con el Apollo 11 en el Mar de la Tranquilidad. Las entrecortadas palabras de Armstrong -"Este es un pequeño paso para el hombre, pero un gran salto para la Humanidad"- se perdieron en el espacio, pero perduraron y cambiaron para siempre la historia.

Tras Armstrong, el programa Apollo condujo a 12 astronautas más hasta nuestro satélite para llevar a cabo diferentes investigaciones. Posteriormente, la NASA se ha centrado en otros objetivos, como Marte, planeta al que ha enviado diversas misiones como el robot Spirit, que investiga actualmente la superficie marciana, o el desarrollo de sistemas más baratos para sus vuelos, lo que ha conseguido con transbordadores espaciales como el Columbia.

Autor: Víctor Moreno

sábado, 4 de octubre de 2008

Encontrada la estrella más masiva del universo

ngc3603_A1.pngLos modelos teóricos sobre formación estelar proponen la existencia de estrellas super- masivas que podrían alcanzar hasta 150 veces la masa del Sol. Sin embargo, no se había descubierto más que una estrella de 83 veces la masa solar. mAhora, astrofísicos de la Universidad de Montreal, en Canadá, han encontrado y “pesado” la estrella más masiva observada hasta la fecha: su masa es 116 veces mayor que la del Sol, por lo que es la primera que se conozca que supera en más de 100 veces la masa de nuestro astro. (foto en el interior)

Localizado en un cúmulo estelar bautizado como NGC 3603 (que se encuentra en la Constelación de Carina), el sistema estelar de esta estrella (el A1) presenta un periodo de rotación de 3,77 días. La masa de la super-estrella fue calculada combinando observaciones realizadas con un instrumento SINFONI, con un espectrógrafo que opera en el proyecto VLT del ESO (European Southern Observatory) en Chile, e imágenes infrarrojas procedentes del Telescopio Espacial Hubble.

Las estrellas del sistema A1 son tan masivas y brillantes que la luz que trasmiten presenta características que sólo poseen las estrellas “Wolf-Rayet”. Estas estrellas son masivas, y presentan temperaturas superficiales de más de 25.000-50.000 K, así como elevadas luminosidades.

Powered by ScribeFire.

Los meteoritos podrían ser el origen de algunos metales preciosos de nuestro planeta

Enviado por redaccion el 25 Septiembre, 2008 - 07:22.asteroid_falls_over_earth.pngAlgunos metales raros y preciosos como el platino, el oro y el iridio podrían haber sido traídos a la Tierra por meteoritos de hierro, según un nuevo estudio a cargo del Dr. Gerhard Schmidt de la Universidad de Maguncia (Alemania), quien expondrá sus hallazgos en el Congreso Europeo de Ciencia Planetaria (EPSC), que se está celebrando en Münster (Alemania) del 21 al 26 de septiembre.

El oro, el platino, el iridio, el paladio y el rodio son ejemplos de elementos altamente siderófilos (HSE), es decir, metales que presentan una tendencia a unirse con el hierro metálico sólido o fundido. Cuando la Tierra aún estaba en formación, su temperatura era muy elevada, y los HSE y otros elementos pesados pasaron de la superficie del joven planeta a su núcleo, rico en hierro y níquel.

Esto lleva a preguntarse por el origen de los HSE hallados en la corteza terrestre. Una de las teorías formuladas es que estos elementos llegaron a la superficie de la Tierra en meteoritos que impactaron en ésta cuando ya se había formado el núcleo.

El Dr. Schmidt y sus colaboradores pasaron doce años analizando las concentraciones de HSE en diversos puntos de impacto de meteoritos y otros lugares de la corteza y el manto terrestre. Al mismo tiempo, estudiaron muestras procedentes de la superficie de la Luna y de meteoritos de Marte.

"Para comprender el origen de los planetas es fundamental conocer la abundancia de HSE en la corteza y el manto de la Tierra, la Luna y Marte", explicó el Dr. Schmidt. "En las muestras que hemos tomado de la corteza superior de la Tierra hemos hallado concentraciones llamativamente uniformes. La comparación de estos niveles de HSE con los de los meteoritos sugiere poderosamente que su origen es cosmoquímico."

Los análisis del Dr. Schmidt revelaron que las concentraciones de HSE halladas en la corteza terrestre son muy superiores a las observadas en unos meteoritos rocosos denominados condritas, que se formaron a partir de material presente en el Sistema Solar primitivo.

No obstante, las proporciones de HSE encontradas son muy próximas a las vistas en meteoritos de hierro o de roca y hierro. Estos asteroides de mayor tamaño generaron suficiente calor interno como para que su núcleo estuviera formado por metal fundido. El Dr. Schmidt ha calculado que bastarían alrededor de 160 asteroides metálicos de aproximadamente 20 km de diámetro para dar lugar a los niveles de HSE que se encuentran actualmente en la corteza terrestre. Aparentemente, el mismo proceso podría haber sucedido en Marte.

"El primer meteorito encontrado en Marte era de hierro. Fue descubierto por el vehículo Opportunity en enero de 2005", recordó el Dr. Schmidt. "Los análisis practicados en los meteoritos marcianos Nahkla, Shergotty y Zagami respaldan sólidamente la idea de un vínculo con ciertos meteoritos de hierro."

El EPSC está organizado por la iniciativa Europlanet, financiada con fondos comunitarios, cuyos propósitos son fomentar la cooperación en la investigación europea en el ámbito de la ciencia planetaria, impulsar la competitividad de Europa en este campo, promover la participación europea en importantes misiones de exploración planetaria y, por último, informar a la sociedad sobre la ciencia planetaria. Europlanet está financiada por el área de actividad de "Infraestructuras de investigación" del Sexto Programa Marco (6PM).

Para obtener más información: Congreso Europeo de Ciencia Planetaria 2008, Página web del Dr. Gerhard Schmidt en la Universidad de Mainz, Europlanet.

Powered by ScribeFire.

sábado, 27 de septiembre de 2008

Crean modelo capaz de descubrir qué piensa una persona

Utilizaron imágenes cerebrales de nueve voluntarios, obtenidas mediante resonancia magnética, para descubrir los patrones neuronales asociados a 60 conceptos.

A continuación “adiestraron” al modelo informático para que fuera capaz de reconocer los patrones de actividad cerebral asociados a dichos conceptos.

De esta forma, una vez determinado un patrón natural, el modelo deduce en qué palabra está pensando el sujeto. El descubrimiento podría servir para conocer mejor el procesamiento del lenguaje por parte del cerebro, así como para comprender la causa de algunas disfunciones del lenguaje.

Powered by ScribeFire.

Relaciones entre Educacion y Tenologìa

Vemos de esta forma como se extiende al conocimiento-y por extensiòn a los aprendizajes-un concepto de obsolescencia del mismo determinado por fenòmenos intrìnsecos a lo tecnològico, como la Ley de Moore y el llamado Darwinismo Tecnològico.

George Siemens, fundador de INTEL, resume asì esta posiciòn en torno al sistema tecnologìa-aprendizaje:

Este esquema asimila la comunicaciòn neuronal a la que se suscita entre los nodos de una red informàtica, lo que conlleva a un reduccionismo tecnològico sobre los procesos que operan en la mente humana.

La amenaza antiintelectual americana

NUEVA YORK. En los últimos años, los Estados Unidos han contribuido más a la inestabilidad mundial que a la resolución de los problemas mundiales. Ejemplos de ello son, entre otros, la guerra de Irak, lanzada por Estados Unidos con falsas premisas; el obstruccionismo de las medidas encaminadas a frenar el cambio climático, una escasa ayuda para el desarrollo y la violación de tratados internacionales, como, por ejemplo, los Convenios de Ginebra. Si bien muchos factores han contribuido a las acciones desestabilizadoras del país, uno poderoso es el antiintelectualismo, ejemplificado recientemente por la repentina popularidad de la candidata republicana a la vicepresidencia, Sarah Palin.

Por antiintelectualismo entiendo en particular una perspectiva agresivamente anticientífica, respaldada por el desdén contra quienes se atienen a la ciencia y sus pruebas. Las amenazas que afronta una gran potencia como Estados Unidos exigen un análisis riguroso de la información conforme a los mejores principios científicos.

El cambio climático, por ejemplo, plantea amenazas terribles al planeta, que se deben evaluar conforme a las normas científicas actuales y la capacidad en desarrollo de la ciencia del clima. El proceso científico mundial llamado Grupo Intergubernamental de Expertos sobre el Cambio Climático (IPCC), que ha obtenido el premio Nobel, ha establecido el criterio del rigor científico para el análisis de las amenazas de cambio climático provocado por la humanidad. Necesitamos a políticos con conocimientos científicos y adeptos al pensamiento crítico basado en las pruebas para que plasmen esos hallazgos y recomendaciones en políticas y acuerdos internacionales.

Sin embargo, en Estados Unidos las actitudes del presidente Bush, de republicanos influyentes y ahora de Sarah Palin han sido lo contrario de científicas. La Casa Blanca ha hecho todo lo que ha podido durante ocho años para ocultar el abrumador consenso científico sobre la contribución humana al cambio climático. Ha intentado impedir que los científicos oficiales hablen sinceramente al público. The Wall Street Journal ha propagado posiciones anticientíficas y seudocientíficas para oponerse a las políticas encaminadas a luchar contra el cambio climático provocado por la humanidad.

Esos planteamientos anticientíficos han afectado no solo a la política del clima, sino también a la política exterior. Estados Unidos fue a la guerra con Irak a partir de los instintos viscerales y las convicciones religiosas de Bush y no de pruebas rigurosas. Asimismo, Palin ha llamado a la guerra de Irak "una tarea inspirada por Dios".

No se trata de personas aisladas, aunque poderosas, que están divorciadas de la realidad. Reflejan el hecho de que un porcentaje importante de la sociedad norteamericana, que actualmente vota principalmente por los republicanos, rechaza o simplemente desconoce pruebas científicas básicas relativas al cambio climático, la evolución biológica, la salud humana y otras esferas. Por lo general, dichos votantes no rechazan los beneficios de las tecnologías resultantes de la ciencia moderna, pero sí las pruebas y las recomendaciones de los científicos sobre políticas públicas.

Según recientes encuestas de opinión realizadas por la Fundación Pew, mientras el 58 por ciento de los demócratas creen que la humanidad está causando el calentamiento planetario, solo el 28 por ciento de los republicanos lo creen. Asimismo, según una encuesta realizada en el 2005, el 59 por ciento de los republicanos que se declaran conservadores rechazaron cualquier teoría de la evolución, mientras que el 67 por ciento de los demócratas progresistas aceptaron alguna versión de la teoría evolucionista.

Desde luego, algunos de esos negacionistas son simplemente ignorantes en materia de ciencia, víctimas de la deficiente calidad de la enseñanza de la ciencia en los Estados Unidos, pero otros son fundamentalistas bíblicos, que rechazan la ciencia moderna, porque interpretan la palabra de la Biblia como literalmente verdadera. Rechazan las pruebas geológicas del cambio climático, porque rechazan la propia ciencia de la geología.

La cuestión a la que nos referimos aquí no es la de la religión contra la ciencia. Todas las grandes religiones tienen tradiciones de intercambio fructífero con la investigación científica y, de hecho, la apoyan. La edad de oro del Islam, hace un milenio, fue también aquella en que la ciencia islámica orientó al mundo. El papa Juan Pablo II declaró su apoyo a la ciencia básica de la evolución y los obispos católicos romanos son convencidos partidarios de que se limite el cambio climático provocado por la humanidad basándose en pruebas científicas.

Varios científicos destacados, incluido uno de los mayores biólogos del mundo, E. O. Wilson, se han dirigido a las comunidades religiosas para que apoyen la lucha contra el cambio climático provocado por la humanidad y la lucha en pro de la conservación biológica, y dichas comunidades religiosas les han respondido en armonía con la ciencia.

El problema es un fundamentalismo agresivo, que niega la ciencia moderna, y un antiintelectualismo agresivo, que ve a los expertos y los científicos como el enemigo. Esas concepciones son las que pueden acabar propiciando que muramos todos. Al fin y al cabo, esa clase de extremismo puede acabar conduciendo a la guerra, al basarse en concepciones pervertidas sobre que una guerra determinada es deseada por Dios en lugar de un fracaso de la política y la cooperación.

En muchas declaraciones, Palin parece decidida a invocar a Dios en sus juicios sobre la guerra, señal siniestra para el futuro, si es elegida. Desde luego, animará a muchos enemigos a recurrir a sus propias variedades de fundamentalismo para que devuelvan el ataque a Estados Unidos. Los extremistas de los dos bandos acaban poniendo en peligro a la gran mayoría de los seres humanos, que no son extremistas ni fundamentalistas anticientíficos.

Resulta difícil saber con certeza a qué se debe el aumento del fundamentalismo en tantas partes del mundo. Lo que está sucediendo en los Estados Unidos, por ejemplo, no ocurre en Europa, sino que es característico de algunas partes de Oriente Medio y del Asia central. Parece que el fundamentalismo surge en épocas de cambios trascendentales, cuando los órdenes sociales tradicionales se ven amenazados. El surgimiento del fundamentalismo estadounidense moderno en política data de la era de los derechos humanos en el decenio de 1960 y, al menos en parte, refleja una reacción violenta entre los blancos contra la fuerza económica y política en aumento de los grupos minoritarios no blancos e inmigrantes en la sociedad estadounidense.

La única esperanza para la Humanidad es la de que se pueda sustituir el círculo vicioso del extremismo por una comprensión mundial compartida de las amenazas en gran escala relacionadas con el cambio climático, los abastecimientos alimentarios, la energía sostenible, la escasez de agua y la pobreza. Los procesos científicos mundiales, como el IPCC, son decisivos, porque representan nuestra mayor esperanza de creación de un consenso basado en las pruebas científicas.

Estados Unidos debe regresar al consenso mundial basado en la ciencia compartida y no en el antiintelectualismo. Ese es el imperativo urgente en el corazón de la sociedad estadounidense actual.

* Jeffrey D. Sachs es profesor de Economía y director del Instituto de la Tierra, de la Universidad de Columbia.

© Project Syndicate 1995-2008

Jeffrey D. Sachs*

Powered by ScribeFire.

Almejas gigantes habrían alimentado a los primeros humanos modernos

* Posted by Martín Cagliani

* Posted by Martín CaglianiAlmejas gigantes habrían alimentado a los primeros humanos modernosAlmejas gigantes podrían haber ayudado a alimentar a nuestros antepasados prehistóricos cuando migraron de África hacia el resto del mundo. Se trata de una especie primitiva descubierta ahora nuevamente.

La especia Tridacna costata representaba el 80 por ciento de las almejas gigantes del Mar Rojo, hoy en día apenas si representan el 1 por ciento de las almejas que viven allí. Al parecer tan sólo viven y vivían en aguas bajas, lo que las hizo vulnerables a la sobre pesca.

Según el investigador Claudio Richter, ecologista marino alemán, la Tridacna costata habría sufrido de las primeras sobre explotaciones que el Homo sapiens ha realizado en este planeta. Ya que la evidencia fósil muestra ejemplares rotos de esta almeja gigante ya a una antiguedad de 125 mil años, durante el último intervalo inter glaciar, o sea el período cálido antes de la ultima gran Glaciación.

Se cree que los humanos modernos, que habían aparecido hace 200 mil años en África, aprovecharon este alimento fácil de conseguir. Según Richter y colegas, estos moluscos podrían haber desempeñado un papel clave en alimentar a nuestros antepasados en un momento crucial, y a la ves sirviendo como una presa primaria debido a su gran tamaño.

Se sabe que los primeros sapiens ya marisqueaban en Sudáfrica hace 165 mil años, con lo que es posible que estos recursos les hubiesen ayudado a expandirse por el continente, y luego por el resto del mundo.

Fuentes: Livescience y Sciencedaly

Powered by ScribeFire.

viernes, 22 de agosto de 2008

El Experimento más Grande de la Historia

Por Nora Bär

De la Redacción de LA NACION

Son los físicos, ingenieros, matemáticos y especialistas en ciencias de la computación que están poniendo en marcha el experimento más

"Esto mueve la frontera del conocimiento. Y no es una forma de decir. Es así, literalmente. Entramos en una región de energía nunca antes estudiada del modo en que vamos a hacerlo", dice desde Suiza María Teresa Dova, investigadora de la Universidad de La Plata (UNLP) y responsable de la participación argentina en el proyecto del Centro Europeo de Investigación Nuclear (CERN, según sus siglas en inglés).

Dova y su grupo tienen asegurado un lugar en "el centro de la acción" del mundo científico del momento, donde la adrenalina fluye a mares mientras ponen a punto los instrumentos científicos que ayudarán a interpretar la maraña de datos que recolectará el colisionador cuando esté funcionando a pleno.

Las dimensiones de esta operación hacen que este experimento sea "lo increíble en busca de lo inimaginable". Para estudiar los más diminutos fragmentos del cosmos, el instrumento más grande del mundo ya se convirtió en el lugar más frío del universo conocido: "Se inyectaron 10.000 toneladas de helio líquido para llevar 1600 imanes superconductores a unos grados por encima del cero absoluto, es decir a-270°C" -explica Dova-. Y eso, a lo largo de 27 km. La tecnología es

tan impresionante que hubo que calcular que con el frío el material se iba a contraer hasta nueve metros. No es apretar un botón y listo."

Y enseguida agrega: "Estamos preparando lo que llamamos «el camino del descubrimiento», porque los hallazgos van a llevar muchos meses y años de trabajo".

El LHC está diseñado para hacer chocar (colisionar) dos haces de protones (partículas que integran el núcleo atómico) que rotan en sentido contrario a velocidades cercanas a la de la luz. Los haces se mueven en el vacío dentro de un gigantesco anillo enterrado a cien metros de profundidad, en promedio, guiados por imanes superconductores, es decir, que no ofrecen resistencia al paso de la corriente eléctrica. Las colisiones se producen dentro de los cuatro principales experimentos del LHC.

Los científicos ya comenzaron a hacer circular haces de protones de prueba y, si todo sigue como está previsto, el 10 de septiembre será la inauguración oficial de las operaciones.

"Los haces de protones son como ramilletes del tamaño de un lápiz -explica Dova-. Tendrán alrededor de 1011 protones (un 1 seguido de 11 ceros). Las colisiones ocurrirán cada 25 nanosegundos (la mil millonésima parte de un segundo). Pero aunque esperamos millones de colisiones por segundo, las que nos sirven para contestar las preguntas que nos hacemos a lo mejor son muy poquitas. Entonces, hay que reducir esa cantidad a sólo 200 por segundo, asegurándose al mismo tiempo de no descartar las que son importantes."

Dova, al frente de un grupo que no sólo incluye a doctorandos de la UNLP y a jóvenes investigadores de la UBA, sino también a científicos del Argonne National Laboratory, de los Estados Unidos, y de la Universidad de Birmingham, entre otros, están desarrollando los algoritmos para seleccionar de entre toda esa maraña los datos

significativos.

"La primera parte del detector es una cámara de «trazas»: son las señales que dejan a su paso y a partir de las cuales tenemos que deducir de qué tipo de partícula se trata. Hay que estudiar mucho y saber mucha física. Estamos preparando todo el análisis para cuando empiecen a acumularse los datos y lo hacemos principalmente con simulaciones. La preparación -tanto para lo que esperamos ver, como para lo inesperado- es brutal, vivimos en un grado de estrés inimaginable porque tiene que estar todo listo y no nos podemos equivocar. Uno de mis estudiantes me contaba que la noche anterior a cada reunión de coordinación no duerme", comenta la investigadora, que por estos días va del hotel a la oficina y de la oficina al hotel... que están ubicados exactamente enfrente uno de la otra.

Dova, madre de dos jóvenes de 20 y 23 años, se graduó en La Plata e hizo su tesis en materia condensada.

"Después de doctorarme, me ofrecieron venir a hacer física experimental de punta al CERN -recuerda la científica-. Lo pensé mucho. «¿Cambiar de tema ahora, pensé, es muy complicado». Pero tomé la decisión y no me arrepiento. Adoro lo que hago, si estuviera en la misma situación volvería a elegir la física de altas energías. Es fascinante. La excitación, el ambiente... Es el lugar donde se juntan las mentes más brillantes para discutir: no hay físico que no haya pasado por el CERN, aunque no sea su tema específico. Me gusta la adrenalina, la competencia, el llegar a un resultado antes que los demás, la presión de tener que cumplir con plazos estrictos... Esto es

un paraíso."

Ing. Ricardo F. Sánchez

Secretario de Comunicaciones

Coordinador de Radioastronomía

Director Editor de Universo Digital (universo.liada.net)

¿Por qué la Tierra NO es plana?

Qué pregunta rara dirá el lector, más uno que viene aquí a Espaciociencia a leer noticias científicas. Cualquier persona común y corriente está al tanto de que nuestro planeta es una bola redonda, tal vez sean menos los que sepan que no es perfectamente circular, sino algo achatado en los polos, pero sin duda cualquiera de ustedes no dudaría en tildar de loco a quien diga que la Tierra es plana.

Y bueno, pero hay gente que así lo cree, hoy en día, sí. Tildan de falsas las imágenes y pruebas que se han acumulado a lo largo de siglos en favor de la redondez de nuestro mundo.

Hay creyentes de la Tierra Planta en el Reino Unido y en Estados Unidos para quienes la “teoría de la Tierra redonda” es una conspiración.

En BBC mundo se habla de un “científico” que defiende la teoría de la Tierra Planta, y el sujeto, John Davis, dice “la Tierra es plana y horizontalmente infinita y se estira horizontalmente sin cesar. Me di cuenta de lo mucho que aceptamos como un hecho dado. Los humanos parecemos felices simplemente aceptando lo que se nos dice, no importa que ello sea contrario a nuestros sentidos”. Eso no es todo “tiene al menos 9.000 kilómetros de profundidad”, según Davis.

En sitios como la Sociedad de la Tierra Plana se dice que "La Tierra es más o menos un disco. Obviamente no es perfectamente plana debido al fenómeno geológico de colinas y valles. Tiene cerca de 39.840 kilómetros de diámetro".

Y no se trata de una broma, o de fanáticos de Mundodisco, son gente que realmente cree en eso. Si hasta tienen una respuesta para la pregunta de ¿por qué nadie se cayó por el borde del disco? "Un rápido examen del mapa de la Tierra plana explica bien la razón. El polo norte es central y la antártica comprende la circunferencia total de la Tierra. Circunnavegar es un tipo de viaje en un amplio círculo a través de la superficie de la Tierra”, absurda desde un punto de vista racional.

Pero el asunto es que simples pruebas que cualquiera puede hacer, ya echan por tierra esta loca teoría. No se trata de creer en lo que un científico diga, sino en algo que cualquier persona puede probar.

Dejemos de lado los satélites que dan la vuelta a nuestro planeta y las fotos tomadas desde el espacio, ya que todo eso es puesto en duda por estos fanáticos. Pero probemos con simples experimentos, como por ejemplo observar a los barcos desaparecer en el horizonte, o el seguimiento de las estrellas y los planetas, todo esto apunta a una idea lógica y racional, que nuestro mundo es esférico. Otra prueba simple, es la que aportó Aristóteles, que fue observar los eclipses de Luna, donde se ve la forma de nuestro planeta.

¿Pero de donde salió esto? ¿Acaso son gente que no dejó de creer en la tierra planta desde la antigüedad? No, son gente de nuestro tiempo.

Una creencia popular es que en Europa se creía en una Tierra Plana hasta que Colón los sacó de su idea loca, y les mostró que el mundo era redondo. Pero no es así, todos sabían que la tierra era redonda desde la época de los griegos. La idea de que vivimos sobre un disco volvió a surgir en el siglo XIX en Inglaterra.

miércoles, 6 de agosto de 2008

El Ojo de Terminator

MADRID.- Una cámara con forma de globo ocular con una pupila roja. Esa es la imagen que tenemos grabada en la retina del conocido personaje interpretado por Arnold Schwarzenegger en Terminator. Algo parecido es lo que han inventado ahora un equipo de científicos de las universidades de Illinois y Northwestern. El primer paso, apuntan, hacia el ojo biónico y la retina artificial.

La naturaleza es sabia. Los sistemas de visión de la mayor parte de los animales tienen una disposición curva, que reduce enormemente la distorsión de las imágenes. Los inventos humanos, como las cámaras fotográficas o de vídeo, se basan, por el contrario, en mecanismos planos lo que obliga a crear complejos sistemas para lograr una imagen lo más nítida posible, sin aberraciones.

Lo que estos investigadores presentan en la revista 'Nature' es, precisamente, la tecnología que permite saltar de un receptor plano a uno curvo. Se trata de un hito de la electrónica que ha roto la barrera de las dos dimensiones. La primera demostración de su uso es un impactante ojo biónico.

¿Son aNoRmAlEs los Matemáticos?

“Habida cuenta de los clichés negativos relacionados con las matemáticas y los matemáticos no es extraño que solo un número reducido de estudiantes opten por un aprendizaje superior”, se queja Heather Mendick, responsable del informe/encuesta realizado con 650 estudiantes pre-universitarios.

La mayoría de los participantes, tanto los que le gusta la materia como los que odian las ecuaciones, pensaban en un matemático como un hombre de cabello blanco obsesionado por los números y carente de cualquier vida social. Con esa etiqueta los estudiantes calificaron a genios como Albert Einstein o John Nash, seguramente influidos por películas como “A Beautiful Mind”.

jueves, 31 de julio de 2008

sábado, 26 de julio de 2008

Augmented Virtual Earth: el mundo en tiempo real

El Origen de las Cosas

viernes, 25 de julio de 2008

El modelo Wikipedia se traslada al mundo científico para acelerar la investigación

| Varios proyectos en la red impulsan el intercambio de información a través de Internet para avanzar en los estudios del genoma. El objetivo es manejar el flujo continuo de datos nuevos para generar nuevas hipótesis. | |

| FUENTE | La Vanguardia Digital | 24/07/2008 |

| |

Wikipedia, la enciclopedia general on line escrita y editada por los usuarios, es uno de los sitios más utilizados de Internet y cuenta con más de dos millones de artículos, en cuya redacción han contribuido seis millones de personas. El modelo ahora puede exportarse al ámbito científico. Gene Wiki y WikiProteins son dos proyectos independientes sobre genes y proteínas que han decidido imitar los mecanismos de la Wikipedia para crear grandes bases de datos que agrupen y vertebren el gran volumen de información que se está generando sobre la actividad de los genes.

"Será una poderosa herramienta para la comunidad científica. Esperamos que muestre cómo el flujo continuo de datos biológicos puede ser manejado y utilizado para generar nuevas hipótesis y descubrimientos", escriben investigadores que impulsan los proyectos en la revista electrónica Plos Biology.

Tanto Gene Wiki como Wikiproteins apuestan por las herramientas Wiki, que permiten crear y editar fácilmente contenidos en Internet enlazando páginas y conceptos. En ambos casos buscan la colaboración voluntaria de miles de expertos e investigadores.

El Gene Wiki está respaldado por científicos estadounidenses de la Universidad de San Diego, la Universidad de Washington y el Instituto de Genómica de la Fundación Novartis de Investigación (GNF). Su propuesta es crear una base de datos sobre genética que esté actualizada continuamente y que sirva de fuente fiable a estudiantes, pedagogos y científicos. El primer paso ha sido colocar en la Wikipedia cientos de embriones de artículos con un resumen del gen, la cadena de componentes y su posición en el cromosoma. Son la base para que otros científicos y expertos aporten sus conocimientos.

"Hay alrededor de 25.000 genes en el genoma humano. Nosotros a tenemos unos 9.000 artículos sobre el tema que estamos colocando en la Wikipedia. Los genes no son islas, están vinculados a otros temas como enfermedades y a otros muchos aspectos de la biología humana y nuestro objetivo es proporcionar una visión completa de todo este material. Hemos empezado con una aportación uniforme para los genes y a partir de ahora la comunidad enriquecerá, corregirá o completará el contenido", explica Andrew Su, investigador del GNF y portavoz de Gene Wiki.

Los impulsores del proyecto señalan que han valorado mucho el modelo a escoger y que han elegido Wikipedia porque tiene un mecanismo participativo muy contrastado. Al tratarse de un tema técnico, esperan menos problemas de vandalismo editor que el que a veces generan materias ideológicas o políticas y en todo caso afirman que los mecanismos de edición que tiene la Wikipedia garantizan unos óptimos resultados. El Gene Wiki ha desechado otros modelos, como el de Citizendium, una biblioteca digital que imita a la Wikipedia aunque utiliza editores profesionales y otros sistemas de control de contenidos. "Wikipedia tiene un volumen de usuarios muy importante, un gran reconocimiento, buenos rankings en los buscadores de Internet y un sistema colaborativo que funciona", dice Andrew Su.

WikiProteins, por su parte, quiere crear una gran base de información sobre conceptos biomédicos, enfermedades y otros datos relativos a las proteínas. Es un sistema independiente de la Wikipedia, pero que también utiliza herramientas Wiki para recopilar, editar y enlazar la información. La idea es organizar los datos que ahora están dispersos, motivar a los expertos para que sumen sus conocimientos y crear una base de consulta abierta a todo el mundo. Barend Mons, biólogo de la Universidad de Rotterdam (Holanda) y cofundador de WikiProteins, señala que hay similitudes de concepto y contenidos entre su proyecto y el Gene Wiki. Y no descarta que puedan compartir esfuerzos: "Hay un gran potencial de sinergia entre ambos y vamos a ver si podemos trabajar juntos porque su planteamiento y el nuestro son complementarios".

Autor: Álex Barnet

El modelo Wikipedia se traslada al mundo científico para acelerar la investigación

| Varios proyectos en la red impulsan el intercambio de información a través de Internet para avanzar en los estudios del genoma. El objetivo es manejar el flujo continuo de datos nuevos para generar nuevas hipótesis. | |

| FUENTE | La Vanguardia Digital | 24/07/2008 |

| |

Wikipedia, la enciclopedia general on line escrita y editada por los usuarios, es uno de los sitios más utilizados de Internet y cuenta con más de dos millones de artículos, en cuya redacción han contribuido seis millones de personas. El modelo ahora puede exportarse al ámbito científico. Gene Wiki y WikiProteins son dos proyectos independientes sobre genes y proteínas que han decidido imitar los mecanismos de la Wikipedia para crear grandes bases de datos que agrupen y vertebren el gran volumen de información que se está generando sobre la actividad de los genes.

"Será una poderosa herramienta para la comunidad científica. Esperamos que muestre cómo el flujo continuo de datos biológicos puede ser manejado y utilizado para generar nuevas hipótesis y descubrimientos", escriben investigadores que impulsan los proyectos en la revista electrónica Plos Biology.

Tanto Gene Wiki como Wikiproteins apuestan por las herramientas Wiki, que permiten crear y editar fácilmente contenidos en Internet enlazando páginas y conceptos. En ambos casos buscan la colaboración voluntaria de miles de expertos e investigadores.

El Gene Wiki está respaldado por científicos estadounidenses de la Universidad de San Diego, la Universidad de Washington y el Instituto de Genómica de la Fundación Novartis de Investigación (GNF). Su propuesta es crear una base de datos sobre genética que esté actualizada continuamente y que sirva de fuente fiable a estudiantes, pedagogos y científicos. El primer paso ha sido colocar en la Wikipedia cientos de embriones de artículos con un resumen del gen, la cadena de componentes y su posición en el cromosoma. Son la base para que otros científicos y expertos aporten sus conocimientos.

"Hay alrededor de 25.000 genes en el genoma humano. Nosotros a tenemos unos 9.000 artículos sobre el tema que estamos colocando en la Wikipedia. Los genes no son islas, están vinculados a otros temas como enfermedades y a otros muchos aspectos de la biología humana y nuestro objetivo es proporcionar una visión completa de todo este material. Hemos empezado con una aportación uniforme para los genes y a partir de ahora la comunidad enriquecerá, corregirá o completará el contenido", explica Andrew Su, investigador del GNF y portavoz de Gene Wiki.

Los impulsores del proyecto señalan que han valorado mucho el modelo a escoger y que han elegido Wikipedia porque tiene un mecanismo participativo muy contrastado. Al tratarse de un tema técnico, esperan menos problemas de vandalismo editor que el que a veces generan materias ideológicas o políticas y en todo caso afirman que los mecanismos de edición que tiene la Wikipedia garantizan unos óptimos resultados. El Gene Wiki ha desechado otros modelos, como el de Citizendium, una biblioteca digital que imita a la Wikipedia aunque utiliza editores profesionales y otros sistemas de control de contenidos. "Wikipedia tiene un volumen de usuarios muy importante, un gran reconocimiento, buenos rankings en los buscadores de Internet y un sistema colaborativo que funciona", dice Andrew Su.

WikiProteins, por su parte, quiere crear una gran base de información sobre conceptos biomédicos, enfermedades y otros datos relativos a las proteínas. Es un sistema independiente de la Wikipedia, pero que también utiliza herramientas Wiki para recopilar, editar y enlazar la información. La idea es organizar los datos que ahora están dispersos, motivar a los expertos para que sumen sus conocimientos y crear una base de consulta abierta a todo el mundo. Barend Mons, biólogo de la Universidad de Rotterdam (Holanda) y cofundador de WikiProteins, señala que hay similitudes de concepto y contenidos entre su proyecto y el Gene Wiki. Y no descarta que puedan compartir esfuerzos: "Hay un gran potencial de sinergia entre ambos y vamos a ver si podemos trabajar juntos porque su planteamiento y el nuestro son complementarios".

Autor: Álex Barnet

¿Qué le pasa al Sol? (Nada)

El Sol está entrando en su tercer año de inquietante calma. Las manchas solares son raras y las llamaradas solares simplemente no ocurren. ¿El "mínimo solar" está durando más de lo que debería? Para hallar la respuesta, un científico de la NASA ha examinado datos sobre la ocurrencia de manchas solares, los cuales han sido recopilados durante siglos. |

Julio 11, 2008:¡Detengan las rotativas! El Sol se está comportando normalmente.

Eso es lo que dice el físico solar de la NASA, David Hathaway. "Ha habido algunos informes últimamente que sostienen que el mínimo solar está durando más de lo que debería. Eso no es cierto. El actual período de calma relacionado con la cantidad de manchas solares se encuentra dentro de las normas históricas para el ciclo solar".

Este informe, que sostiene que no hay nada que informar, es de interés periodístico debido al creciente rumor en círculos populares y académicos de que algo anda mal en el Sol. El Sol está pasando más tiempo de lo normal sin producir manchas solares, declaró un reciente comunicado de prensa. Un examen cuidadoso de los datos, sin embargo, sugiere algo diferente.

Pero primero, un informe de la situación: "El Sol se encuentra ahora cerca del punto bajo de su ciclo de actividad de 11 años", dice Hathaway. "A esto lo llamamos 'mínimo solar'. Es el período de calma que separa un máximo solar de otro".

Arriba: El ciclo solar correspondiente al período 1995-2015. La curva "ruidosa" traza el número de manchas medidas; la curva suave representa las predicciones. Crédito de la imagen: D. Hathaway/NASA/MSFC. [Más información]

Durante un máximo solar, enormes manchas solares e intensas ráfagas solares ocurren diariamente. En Florida, es posible ver auroras. Las tormentas de radiación dejan fuera de servicio los satélites. Las interrupciones de las señales de radio frustran a los operadores de radioaficionado. El último de estos episodios tuvo lugar alrededor de los años 2000-2001.

domingo, 20 de julio de 2008

“Saltos” del Sistema Solar podrían haber extinguido a los dinosaurios

- Posted by Martín Cagliani

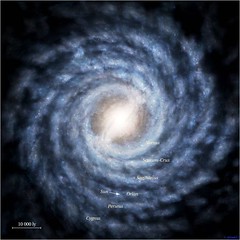

El sol es una más de tantas estrellas que hay en nuestra galaxia,

Científicos del centro Cardiff de Astrobiología, construyeron un modelo computado del movimiento de nuestro sistema solar y descubrieron que va a los “saltos”, arriba y abajo del plano de la galaxia. Cuando el Sistema Solar pasó a través de la parte más densa del plano, fuerzas gravitacionales de los gigantes gaseosos y las nubes de polvo sacaron a los cometas de su órbita, y terminaron zambulléndose en nuestro sistema solar. Algunos de ellos colisionaron con

Científicos del centro Cardiff de Astrobiología, construyeron un modelo computado del movimiento de nuestro sistema solar y descubrieron que va a los “saltos”, arriba y abajo del plano de la galaxia. Cuando el Sistema Solar pasó a través de la parte más densa del plano, fuerzas gravitacionales de los gigantes gaseosos y las nubes de polvo sacaron a los cometas de su órbita, y terminaron zambulléndose en nuestro sistema solar. Algunos de ellos colisionaron con

El equipo de Cardiff descubrió que el Sistema Solar pasa a través del plano galáctico cada 35 o 40 millones de años. Evidencias de cráteres en

Los períodos de bombardeos de cometas también coinciden con extinciones en masa, como por ejemplo la sufrida hace 65 millones de años en la cual desaparecieron los dinosaurios. Según los estudios de los científicos, nuestra posición actual en

Pero los científicos no creen que hayan sido todos malos esos “saltos”, ya que si bien fue malo para los dinosaurios, también fue bueno para que la vida se expandiese. Ya que una de las teorías más aceptadas sobre el origen de la vida, sugiere que fueron los cometas los que trajeron los ladrillos necesarios para que la vida se hiciera camino.

Búsqueda de Vida Microbiana en Marte

La vida en el planeta rojo podría estar escondida bajo sus rocas, o bien dentro de ellas. Un nuevo estudio ofrece una simplificada técnica para la detección biológica y moléculas prebióticas que quedan atrapadas dentro de los minerales.

Estudiando siete muestras de jarosita (sulfato de potasio e hierro hidratado básico) recogidas de diversos puntos de la Tierra, un grupo de investigadores ha sido capaz de identificar los aminoácidos, los componentes básicos de las proteínas, que presumiblemente habían sido incorporados al mineral en su estructura cristalina.

No es la primera vez que compuestos biológicos se detectan en el interior de una roca, pero este método tiene la ventaja de que funciona “en concentraciones muy bajas sin previa preparación de la muestra”, dice Nancy Hinman, de la Universidad de Montana.

Hinman y sus compañeros piensan que su innovadora técnica sería perfecta para estudiar muestras de Marte de futuros viajes al planeta rojo.

La jarosita, que fue descubierta en 1852 en el barranco del Jaroso, Almería (España), se descubrió en 2004 en Marte, por el Opportunity, uno de los rovers exploradores de la NASA. Esto fue declarado por los científicos una prueba clara de la existencia de agua en tiempos anteriores en el planeta.

“La formación de la jarosita sin microbios y sin agua sería extremadamente lento”, dice Hinman. Es muy difícil decir con seguridad si la jarosita podría formarse sin ayuda de microbios. “La Tierra no es un buen banco de pruebas para los procesos abióticos. No sé de ningún medio ambiente que carezca de microorganismos”.

Pero tal vez Marte sí sea un buen banco de pruebas, ya que hay teorías bajo las cuales se podría formar jarosita en ausencia de vida.

“Al ser un medioambiente muy oxidante el de Marte”, dice Michelle Kotler, “la jarosita podría surgir de la meteorización química de las abundantes rocas de basalto”.

Sin embargo, también está la interesante posibilidad de que la jarosita en Marte se deba a la existencia de microbios come-rocas. De ser así, los restos de estos microbios quedarían bloqueados por el mineral. “Es como un cubo de basura mineral”, explica Nancy Hinman.

Las anteriores técnicas para el estudio de la jarosita implicaban la disolución de esta en alguna sustancia mixta, lo cual diluía la muestra y se arriesgaba a la introducción de contaminación. Sin embargo, la nueva técnica propuesta por Hinman y sus compañeros no requiere la preparación de la muestra, usando tecnología láser. Con un sólo disparo láser, se vaporiza una pequeña porción de la superficie de cristal, la cual pasa a través de un espectómetro de masas, que identifica cada ion por la cantidad de masa y carga que tiene.

En cuatro de las siete muestras analizadas en la Tierra, los científicos detectaron glicina, el más pequeño de los aminoácidos necesarios para las proteínas.